日志

叙述:NDIA H100 与 H200 GPU 比较:两款 GPU 性能评估

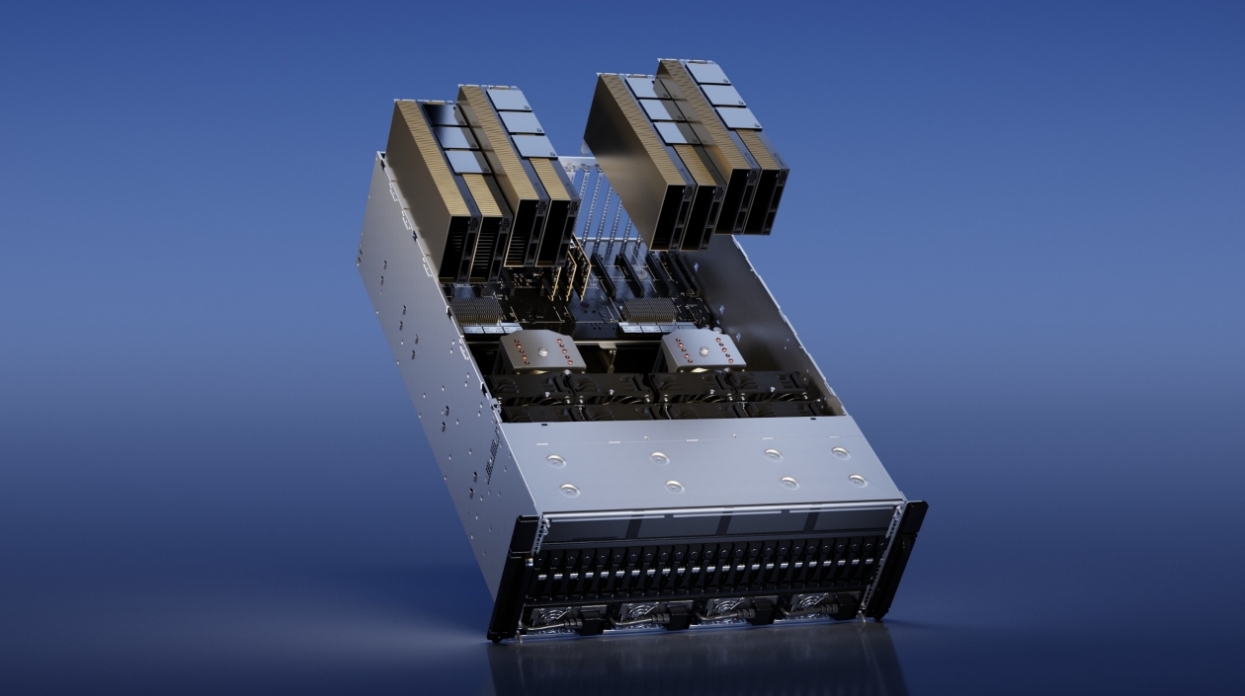

NDIA的H200GPU在AI社区引起了极大的轰动,它提供了显著更高的内存容量——大约是其前身H100的两倍。这些GPU共享强大的Hopper架构,专为高效管道理广泛的AI和HPC任务而量身定制。脚踏实地的对gpu服务器出租进行深入研究是追求发展的唯一办法。深圳市捷智算科技有限公司一家AI算力租赁平台,提供多样化的GPU服务器出租服务,包括NVIDIA A100、A800、H100和H800全系列高性能显卡。适合AI大模型训练GPU集群和大模型训练算力租赁,我们的解决方案支持企业快速扩展数据处理能力,优化成本效益。https://www.gogpu.cn/news/detail/210.html

NDIAH100一经推出,就为AI性能标准带来了重大转变。随着我们期待2024年H200的到来,人们对它超越H100成就的进步程度的好奇心也愈发强烈。深入研究它们各自的架构方面以及Ndia对H200的预览,使我们能够评估比较终用户的潜在性能增强。

NDIAH100架构和规格

NDIAH100是NDIA迄今为止功能比较强大、可编程的GPU,具有多项架构增强功能,例如与其前代产品A100相比具有更高的GPU核心频率和更强大的计算能力。

H100引入了新的流多处理器(SM),可处理GPU架构内的各种任务,包括:执行CUDA线程,这是NDIA编程模型中的基本执行单元。执行传统浮点计算(FP32、FP64)。结合专用核心,如TensorCores。

对于相同数据类型,H100SM执行矩阵乘法累加(MMA)运算的速度是A100的两倍。此外,与A100SM相比,它在浮点运算方面现了四倍的性能提升。这是通过两项关键改进现的:1、FP8数据类型:H100引入了一种新的数据格式(FP8),与A100的标准FP32(32位)相比,它使用8位,从而允许更的计算,但精度略有降低。2、改进的SM架构:由于内部架构的增强,H100SM对于传统数据类型(FP32、FP64)的处理能力本质上是其两倍。

H100是比较好的GPU吗

NDIAH100一经推出,就因其先进的架构、广泛的内存带宽和卓越的AI加速功能而被视为AI和HPC工作负载的高级GPU。它专为大规模深度学习、科学计算和数据分析而。然而,“比较佳”GPU可能会因具体用例、预算和兼容性需求而异。

H100采用第四代TensorCore,性能较上一代A100有显著提升。

此外,H100还引入了全新的Transformer引擎,专门用于加速Transformer模型的训练和推理,这对于自然语言处理(NLP)至关重要。该引擎将软件化与HopperTensorCore相结合,以现大幅加速。

该引擎在两种数据精度格式(FP8和FP16)之间动态切换,以现更的计算和比较小的精度损失,并自动处理模型内这些格式之间的转换以获得比较佳性能。

与A100相比,H100Transformer引擎在大型语言模型上提供高达9倍的AI训练速度和30倍的AI推理速度。

NDIAH100强大的NVLink络互连可现多达256个GPU在多个计算节点之间的通信,使其成为处理海量数据集和复杂问题的理想选择。安全MIG技术允许将GPU划分为安全、大小合适的例,从而化较小工作负载的服务质量。

NDIAH100是首款真正异步的GPU,能够将数据移动与计算重叠,从而比较大限度地提高整体计算效率。此功能确保GPU能够与处理任务并行执行数据传输,从而减少空闲时间并提高AI和高性能计算(HPC)工作负载的吞吐量。张量内存加速器(TMA)可进一步提高效率,从而化GPU上的内存管道理。通过简化内存操作,TMA减少了管道理内存带宽所需的CUDA线程,从而释放更多CUDA线程用于核心计算。

另一项创新是线程块集群,它将多个线程分组,以现H100内多个处理单元之间的高效协作和数据共享。这扩展到异步操作,确保高效使用TMA和TensorCores。此外,H100引入了新的异步事务屏障,以简化不同处理单元之间的通信。此功能允许线程和加速器高效同步,即使位于不同的芯片部件上也是如此。

NDIAH100与H200基准测试

在我们之前对NDIAH100的基准测试中,我们介绍了它的内存规格和其他功能。在本文中,我们将关注NDIAH200。

尽管道H100令人印象深刻,但H200的功能更进一步。它是首款采用HBM3e内存的GPU,内存容量高达141GB,几乎是H100的两倍。这种增加的内存大小对于AI至关重要,允许将更大的模型和数据集直接存储在GPU上,从而减少与数据传输相关的延迟。H200还提供48TBs的内存带宽,与H100的335TBs相比有显着提升,从而能够更地将数据传输到处理核心,这对于高吞吐量工作负载至关重要。

对于内存密集型HPC任务(例如天气建模),H200的卓越内存带宽可促进GPU内存和处理核心之间更高效的数据流动,从而减少瓶颈并缩短洞察时间。据报道,HPC任务的性能提升高达110倍,凸显了H200处理高度复杂模拟的潜力,使研究人员和工程师能够在更短的时间内取得更多成果。

H200在FP64和FP32操作的性能指标上与H100相当,FP8和INT8性能没有差异,达到3,958TFLOPS。这仍然令人印象深刻,因为INT8精度平衡了计算效率和模型准确性,使其成为计算资源有限的边缘设备的理想选择。

H200提供增强的性能,同时保持与H100相同的能耗水平。通过将LLM任务的能耗降低50%并将内存带宽增加一倍,它有效地将总拥有成本(TCO)降低了50%。

H200比H100多少

NDIAH200GPU超越了H100,在特定生成式AI和HPC(高性能计算)基准测试中性能提升高达45%。这一改进主要归功于H200的HBM3e内存容量增加、内存带宽增加以及热管道理化。性能增强的程度可能因特定工作负载和配置而异。

NDIAH100与H200MLPerf推理基准测试

让我们来看看NDIAH100与NDIAH200在MLPerf推理分析方面的对比。MLPerf基准测试是行业标准测试,旨在评估不同平台和环境中机器学习硬件、软件和服务的性能。它们为比较机器学习解决方案的效率和速度提供了可靠的衡量标准,帮助用户确定适合其AI和ML项目的比较佳工具和技术。

高级AI模型的开发人员需要测试他们的作品。推理对于大型语言模型(LLM)理解新的、未见过的数据至关重要。当呈现不熟悉的信息时,推理使模型能够根据其训练掌握数据中的上下文、意图和关系。然后,模型按顺序生成标记(例如单词)。

在推理过程中,LLM利用获得的上下文和之前生成的标记来预测序列中的下一个元素。此过程使LLM能够生成全面的输出,论是翻译句子、编写各种形式的创意文本,还是提供问题的全面答案。

在比较H100和H200在处理推理任务方面的表现时,我们关注的是它们在特定时间范围内能够生成的标记数量。这种方法为评估它们的性能提供了一个用的指标,特别是在与自然语言处理相关的任务中。

根据MLPerfInferencev40针对Llama270B型号的性能基准测试,H100在离线场景下现了22,290个令牌秒的吞吐量。相比之下,H200在相同场景下现了31,712个令牌秒的吞吐量,性能显著提升。

在服务器场景下,H100的吞吐量达到了21504个Tokens,而H200的吞吐量达到了29526个Tokens,说明在服务器场景下,H200相比H100吞吐量提升了37%,性能提升非常明显。此外,在离线场景下,性能提升也非常明显。

原因概括如下:

1、H200的内存和带宽提升:与H100相比,H200拥有更大的内存(141GB)和更高的带宽(48TBs),分别约为18倍和14倍。这使得H200能够容纳更大的数据量,从而减少了从较慢的外部内存不断获取数据的需要。增加的带宽有助于加内存和GPU之间的数据传输速度。因此,H200需借助张量并行或流水线并行等复杂技术即可处理大量任务。

2、H200的推理吞吐量有所提升:由于没有内存和通信瓶颈,H200可以将更多的处理能力分配给计算,从而加推理速度。在Llama测试中进行的基准测试证明了这一势,即使在与H100相同的功率水平(700WTDP)下,H200也能现高达28%的提升。

3、H200的性能提升:基准测试表明,当功耗配置为1000W时,H200在Llama测试中的性能提升幅度比H100高达45%。这些比较凸显了H200GPU相对于H100所现的技术进步和性能提升,特别是在通过更大的内存容量、更高的内存带宽和改进的热管道理来管道理Llama270B等生成式AI推理工作负载的需求方面。

加入捷智算平台

如果您是AI研究员、深度学习专家、机器学习专业人士或大型语言模型爱好者,我们希望听到您的声音!加入捷智算平台将让您尽早体验强大功能,并获得免费积分,帮助您现项目。

不要错过这个激动人心的机会,彻底改变您开发和部署应用程序的方式。